首页

技术小册

AIGC

面试刷题

技术文章

MAGENTO

云计算

视频课程

源码下载

PDF书籍

「涨薪秘籍」

登录

注册

给ChatGPT“打绩效”

改进(Evolve):进行试验与调整

示例:自动驾驶试乘报告

让 ChatGPT 完成大而复杂的任务

上下文学习:为ChatGPT提供范例

用链式思维提高 ChatGPT 的逻辑能力

自一致性:利用“投票”获得可靠答案

知识生成提示

组合式创新

ChatGPT+领域知识

ChatGPT+工具

ChatGPT+其他AI工具

用ChatGPT做数据分析

利用ChatGPT制作自己的应用

LangChain:大语言模型开发框架

Claude:ChatGPT的孪生姐妹

PaLM 2:来自谷歌的实力对手

HuggingChat:“抱抱脸”聊天机器人

ChatGLM:来自清华大学的语言模型

Alpaca&Vicuna:语言模型之羊驼家族

其他大语言模型

当前位置:

首页>>

技术小册>>

ChatGPT与提示工程(下)

小册名称:ChatGPT与提示工程(下)

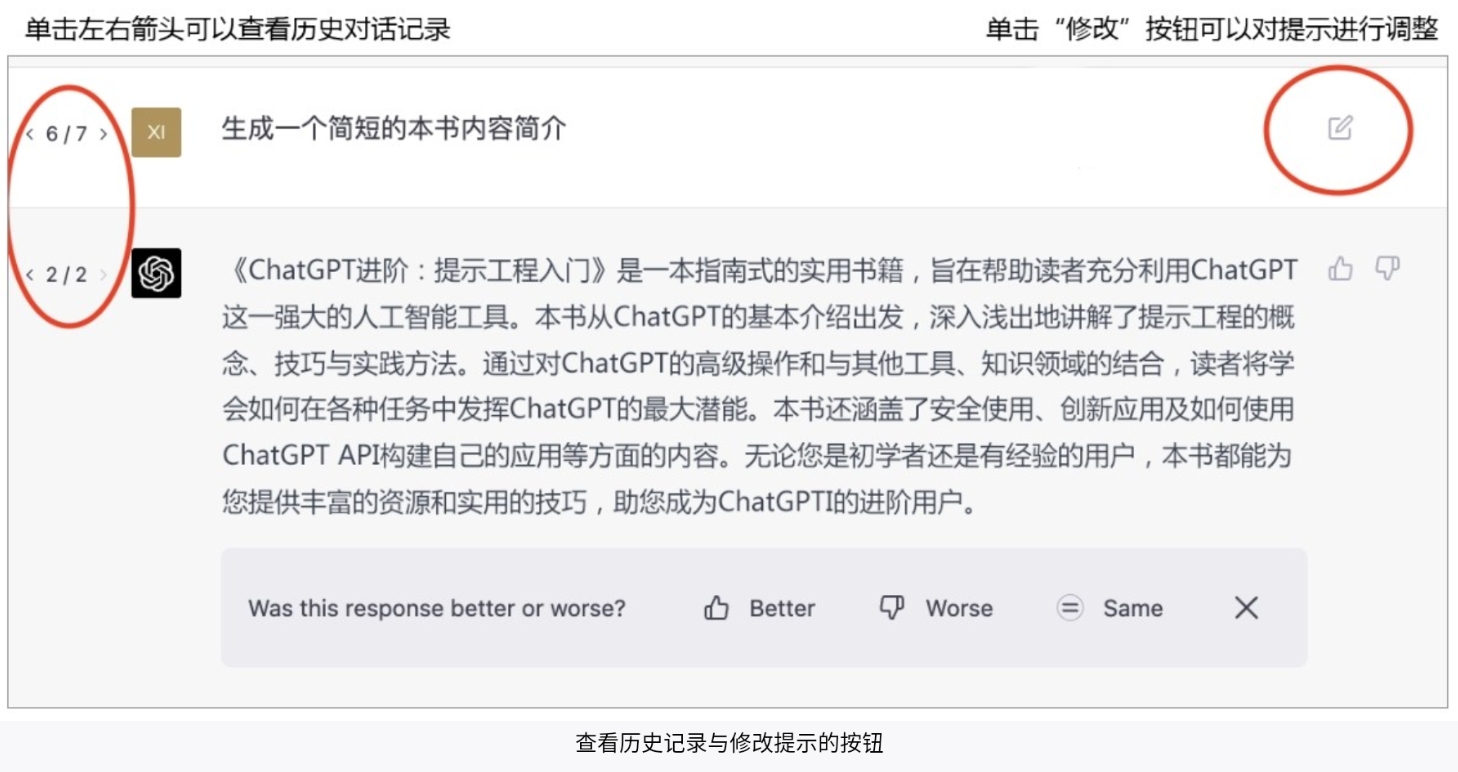

在我们与ChatGPT的互动过程中,有时生成的回答并不完全符合我们的预期。为了得到满意的回答,我们需要对指令进行改进,采取一些策略进行调整和优化。在改进时,可根据实际情况灵活运用不同的策略,以便获得更好的结果。 根据不同情境与生成答案的缺点,我们需要对指令进行调整、在对话中加以指正或重新生成回答。将三种方法组合起来,重复、多次使用,从而得到满意的回答。 那么,面对不满意的回答,我们该如何进行改进呢? 在使用ChatGPT的过程中,我们可能会遇到三种情况:第一种是指令给得不够清楚;第二种是ChatGPT做得不好或回答有错误;第三种是运气不好,遇到糟糕的回答。 1.指令给得不够清楚 解决方案:从回答的不足之处着手,改进背景、角色、目标与增加/修改关键结果。 当我们发现ChatGPT生成的回答不理想时,首先要考虑的是我们是否给出了足够清楚的指令。在这种情况下,我们可以检查我们的提示,看看指令是否给得不够清楚,进而改进提示。 改进背景:检查提供给ChatGPT的信息是否充足。 改进角色:可以酌情添加修饰词,或更换新角色。 改进目标:检查是否明确说明了要生成什么内容。 增加/修改关键结果:若ChatGPT的回答没有体现出你想要的内容,可以在关键结果中补充说明要求。  查看历史记录与修改提示的按钮 2.ChatGPT做得不好,或回答有错误 解决方案:在后续对话中要求ChatGPT改进有缺点的回答。 有时,即使我们的指令已经足够清楚,ChatGPT仍然会生成不理想的回答。在这种情况下,我们可以在接下来的对话中指出回答中的错误与不足,让ChatGPT重新回答。 3.运气不好,遇到糟糕的回答 解决方案:尝试在提示不变的情况下重复生成回答,优中选优。 ChatGPT的回答是具有随机性的,使用相同的提示也会输出不同的回答。在某些情况下,我们可能只是碰巧遇到了不太好的回答。这时,我们可以使用相同的提示(输入),让ChatGPT多次生成回答,再从中挑选出最佳回答。  重新生成回答按钮 需要注意的是,以上三种解决方案通常需要组合起来重复、多次使用,才可以得到满意回答。提示工程本身就是一门高度依赖经验的工程科学,我们在使用和改进的过程中可以将以上三种情况所对应的解决方案灵活组合,从而得到想要的结果。

上一篇:

给ChatGPT“打绩效”

下一篇:

示例:自动驾驶试乘报告

该分类下的相关小册推荐:

AI时代项目经理:ChatGPT与项目经理(中)

AIGC:内容生产力的时代变革

ChatGPT原理与实战:大型语言模型(中)

程序员必学数学基础课

机器学习训练指南

与AI对话:ChatGPT提示工程揭秘

AI大模型入门指南

AI时代项目经理:ChatGPT与项目经理(上)

AI降临:ChatGPT实战与商业变现(下)

ChatGPT通关之路(下)

PyTorch 自然语言处理

巧用ChatGPT轻松学演讲(上)