首页

技术小册

AIGC

面试刷题

技术文章

MAGENTO

云计算

视频课程

源码下载

PDF书籍

「涨薪秘籍」

登录

注册

认识ChatGPT

ChatGPT有多大的能力

认识ChatGPT的局限性

术语:提示与提示工程

如何挖掘提示工程的巨大威力

与ChatGPT的沟通模型

人工智能角度看提示工程

如何用AI改造工作

提示:分割指令和上下文

使用标记语言标记输入格式

利用有序列表与无序列表

将我们的需求量化

提示:要做什么和不要做什么

巧妙利用ChatGPT的接龙特性

与ChatGPT产生多轮对话

使用ChatGPT插件

什么是自然语言处理任务

文本摘要:提炼文本精华

文本纠错:检测和修正文本错误

情感分析:挖掘文本中的情感倾向

机器翻译:跨语言的文本转换

关键词抽取:从文本中识别主题

问题回答:用ChatGPT学知识

生成式任务:用ChatGPT做内容创作

BROKE框架介绍

背景:信息传达与角色设计

角色(Role):AI助手的角色扮演游戏

当前位置:

首页>>

技术小册>>

ChatGPT与提示工程(上)

小册名称:ChatGPT与提示工程(上)

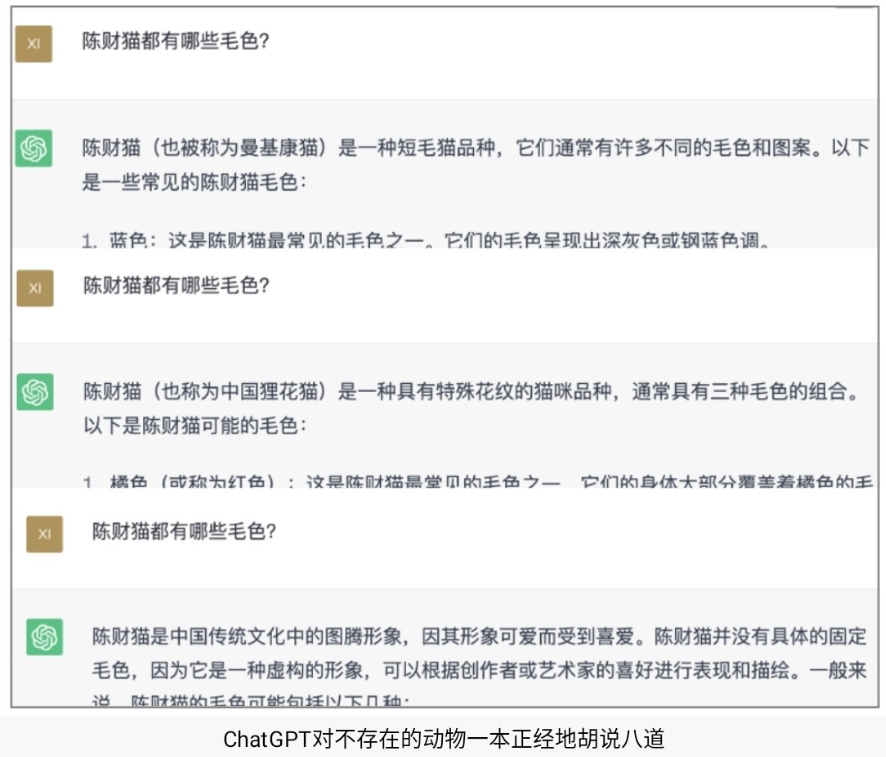

ChatGPT虽然很智能,也很强大,但它并不是完美的。下面将介绍ChatGPT的一些缺点,在使用它时需多加注意。 1.3.1 大语言模型的“幻觉”现象 ChatGPT具有“幻觉”的现象。通俗地说,“幻觉”就是一本正经地胡说八道。这是指大语言模型输出一系列看似符合逻辑,但实际是错误或并不存在的虚假事实。这种现象在自然语言生成中尤为明显,如ChatGPT等对话系统可能会产生与输入事实冲突的内容,或者引用虚构的论文和数据。  随着模型越来越厉害,越来越可信,用户可能会过度依赖它们。当模型变得更加真实时,“幻觉”可能变得更加危险,因为当模型对用户在他们熟悉的领域提供真实信息时,用户会建立对模型的信任,从而放松警惕。 随着科学家们的努力,“幻觉”的现象已经大幅减少了。在OpenAI的内部评估中,GPT-4产生事实回应的可能性比GPT-3.5增加了40%。 对于GPT-4或其他类似模型可能产生的“幻觉”带来的影响,可以采取以下几种措施。 (1)事实检查:对于重要的信息,特别是那些可能影响决策的信息,我们应该通过其他可信的来源进行确认。 (2)多元化信息源:不要完全依赖人工智能模型来获取信息。尽可能地使用多种不同的信息源,包括人类专家和其他可靠的信息源。 (3)了解人工智能的限制:GPT-4和其他人工智能模型并不完美,它们可能产生错误的信息,理解这些限制是不被人工智能“牵着鼻子走”的前提条件。 1.3.2 有限的上下文:ChatGPT的“失忆症” 我们在与ChatGPT聊天时,往往会觉得这个过程是线性的,是“你说一句,我答一句”的过程,但是事实并非如此。有时候,我们会发现如果在同一个对话中聊得太多,ChatGPT就会忘记最开始的对话内容,这是为什么呢?下面我们可以通过一个故事来理解。 ChatGPT有一个秘密,它其实是一个失忆症患者。就像一个人的记忆总是停留在过去某一天,过了那一天他就再也记不住新的事情了。为了不让别人知道他的秘密,他每天都会把和别人的对话记在一个日记本上。每次和别人聊天之前,他都会翻阅日记本,回顾之前的对话,然后再开始聊天。这样一来,别人就不会发现他其实已经失去了记忆。 接下来,我们根据这个故事来回答三个问题。 问题1:为什么ChatGPT会“忘记”之前的内容? “日记本”的容量即“上下文”的大小。以GPT-4的32k版本为例,它的“日记本”容量为32000个token。根据OpenAI公司的描述,1个token通常可以对应普通英文文本中的4个字符,大约相当于一个英文单词的3/4。也就是说,32000个token大约相当于两万多个英文单词。不过,随着技术的发展,上下文会越来越长,如ChatGPT的竞争对手Claude2的“日记本”就有足足10万个token之大。 问题2:为什么不相关的话题最好在不同对话(Chat)里聊? 因为ChatGPT会一次性读入所有内容,即对话中所有的话题都包括在内,所以我们与ChatGPT对话并非线性的。虽然ChatGPT会对当前话题进行回答,但是它仍然会对距离较远的信息做出反应,那些信息会对回答产生干扰。 问题3:我们和ChatGPT聊天时会觉得它越聊越聪明,是因为我们对它进行了“训练”吗? 模型训练是一个专业的过程,其目的是调整和优化模型的参数,即模型的内部结构。此过程由专业的OpenAI研究人员执行,我们的角色主要是ChatGPT的用户,而不是其训练者。 尽管OpenAI可能会用我们与ChatGPT产生的对话数据作为训练资料,但是,我们的互动过程并不构成对模型的“训练”,这是因为我们并没有直接参与到模型参数的优化和调整中。 我们每一次在与ChatGPT进行对话时,ChatGPT本体都是一样的,只不过“日记本”不同,“日记本”的信息越多,ChatGPT对我们的需求、问题背景等的了解就越多,所以就看起来更聪明了。 1.3.3 隐私漏洞与安全隐患 在使用ChatGPT的过程中,会存在个人隐私或组织机密信息泄露等问题。我们在聊天过程中经常会不经意地透露一些个人隐私或机密信息,这也许会导致ChatGPT等对话系统不小心知道很多“不该知道的东西”,从而发生信息泄露和滥用的情况。 下面我们来看一个生动的示例。 小明是一个青少年,他在和ChatGPT聊天时,为了获得更个人化的回复,谈到了他暗恋的女孩子。虽然ChatGPT无法真正了解小明的感情,但它还是通过记录这些聊天信息,来分析和利用小明的兴趣爱好、词汇量、表达方式等数据。这些看似无害的个人信息在大数据时代可能会被别有用心的人利用。一旦这些信息被别有用心的人获取和分析,小明的隐私安全就会面临风险。 同时,大语言模型庞大的规模使其难以解释生成的具体语言输出。因此,如果泄露了隐私信息,也很难追根溯源并修复问题。同时,这也加大了研发者和使用者的无端风险。那么,如何在不损害ChatGPT性能的前提下,加强其对数据隐私和安全的保护便成了机器学习领域一个亟待解决的问题。要解决这个问题,需要在数据处理、模型结构与训练过程等各个环节下功夫。此外,相关法律法规也需要与时俱进,针对人工智能系统中可能存在的数据隐私泄露问题给予更多的关注和规范。 从使用者的角度出发,我们在和ChatGPT聊天的过程中可以避免提供过于个人化或敏感的信息。同时,我们也要提高自己对于人工智能和大数据等技术的安全认知,了解ChatGPT等系统的工作机制,在实际使用中保护好自己的数据隐私。 如果特别在意隐私问题,可以在ChatGPT的设置中选择不让OpenAI使用你的数据训练模型。 1.3.4 大语言模型的偏见 ChatGPT等大语言模型也存在偏见(Bias)的问题,它们在训练或标注过程中,所吸收知识中的偏见会影响其回答和判断。在使用ChatGPT模型时,这些偏见可能会导致其回答出现歧视、不客观或有害内容,因此,我们必须采取措施避免在使用时遇到这些问题。 例如,如果ChatGPT的训练数据中对某一性别或种族的描述显著多于其他方,那么它在回答问题时的态度也可能会因为这种偏差而有所倾斜,这会导致其对某些群体的言论产生不必要的引发公平和道德争议的问题。为应对这一点,在大语言模型的训练过程中,研究者应选择更加中立和全面的数据,避免过度偏重某一方。 再如,ChatGPT的训练和标注过程通常依靠人工参与,而人自身难免会带有某些偏见和主观倾向,这可能会通过设定聊天内容的“真实”或“正确”答案,传递给ChatGPT并影响其判断标准。为解决这一问题,研究者们应采用更加客观和去个人化的自动方式来补充人工标注,减少主观偏差。

上一篇:

ChatGPT有多大的能力

下一篇:

术语:提示与提示工程

该分类下的相关小册推荐:

ChatGPT商业变现

AI 时代的软件工程

深度强化学习--算法原理与金融实践(二)

人工智能超入门丛书--知识工程

ChatGPT写作PPT数据与变现

深度学习之LSTM模型

巧用ChatGPT轻松学演讲(上)

ChatGPT原理与实战:大型语言模型(下)

ChatGPT使用指南

巧用ChatGPT轻松玩转新媒体运营

快速部署大模型:LLM策略与实践(下)

AI Agent 智能体实战课